Từ khi trí tuệ nhân tạo (AI) bùng nổ trên toàn cầu, một trào lưu mới nhanh chóng lan rộng trên các nền tảng video như YouTube: các video hướng đến trẻ nhỏ được sản xuất bằng AI với hình ảnh bắt mắt nhưng nội dung khó kiểm soát, không đảm bảo yếu tố lành mạnh.

Những video này thường sử dụng nhân vật hoạt hình nổi tiếng hoặc được tạo ra bởi AI, đưa chúng vào các tình huống kỳ quái, phi logic, thậm chí mang yếu tố kinh dị hoặc bạo lực. Chúng có đặc điểm dễ nhận thấy như màu sắc sặc sỡ, âm thanh ồn ào và kịch bản rời rạc. Mục tiêu chính không phải là giáo dục hay giải trí lành mạnh mà là thu hút lượt xem nhờ đánh trúng thuật toán đề xuất và từ khóa thịnh hành mà trẻ em hay tìm kiếm – bất chấp tác động tiêu cực tới nhận thức và tâm lý non nớt của người xem nhỏ tuổi.

Cùng lúc, xu hướng "kiếm tiền nhanh" từ AI cũng khiến nhiều người chia sẻ cách sử dụng các công cụ như ChatGPT, ElevenLabs, Adobe Express để sản xuất video hoạt hình đơn giản nhưng có thể đạt hàng triệu lượt xem và mang lại doanh thu đáng kể.

Nội dung trong các video này thường được "ngụy trang" bằng hình ảnh các nhân vật quen thuộc như Minion, Elsa hay thú cưng dễ thương. Tuy nhiên, phần nội dung ẩn sau lớp vỏ bắt mắt lại rất đáng lo. Có video mô tả Minion biến hình thành quái vật dưới cống, hay nhân vật hoạt hình bị bạo hành tàn nhẫn.

Các video cho trẻ em có nội dung bạo lực hoặc vô nghĩa

Các video cho trẻ em có nội dung bạo lực hoặc vô nghĩa

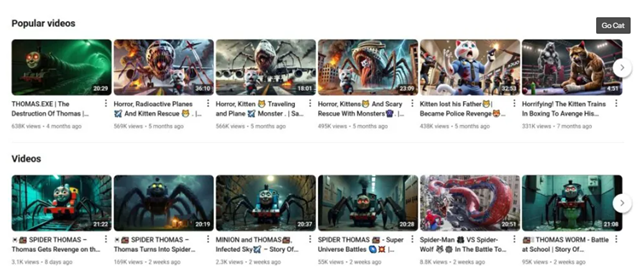

Một ví dụ là kênh "Go Cat", đăng tải các video về mèo con nhưng lại có cảnh chúng bị mèo mẹ đánh đập. Dù giới thiệu nội dung là “giàu trí tưởng tượng và phù hợp với trẻ nhỏ”, thực tế lại thể hiện sự bạo lực, thậm chí khiến người lớn cũng thấy khó chịu.

Không ít video khác lợi dụng từ khóa đơn giản như "minions" hay "cute cats" để chen vào danh sách gợi ý bên cạnh video giáo dục, sử dụng thêm hashtag như #funnycat, #familyfun hay #animalrescue nhằm qua mặt thuật toán và gây hiểu lầm cho người xem.

Các chuyên gia lo ngại rằng xu hướng này đang khiến mạng Internet tràn ngập “video rác”, chiếm lĩnh không gian giải trí trực tuyến của trẻ em. Nhiều kênh còn cố tình làm hoạt hình 3D theo phong cách giống Cocomelon – một thương hiệu nổi tiếng dành cho thiếu nhi – để đánh lừa phụ huynh. Các sản phẩm này thường bị sản xuất một cách gấp gáp, thiếu sáng tạo, với mục đích duy nhất là kiếm tiền từ lượt xem.

Hiện tượng này khiến nhiều người nhắc lại vụ bê bối "Elsagate" từng gây chấn động vào năm 2017, khi hàng nghìn video có vẻ ngoài thân thiện với trẻ nhỏ nhưng lại chứa nội dung bạo lực, tình dục bị phát hiện. Khi đó, YouTube đã phải xóa hàng loạt video, gỡ bỏ quảng cáo và đình chỉ nhiều kênh vi phạm.

Tuy nhiên, với khả năng của AI hiện nay, tình hình còn trở nên phức tạp hơn nhiều. Các công cụ AI tạo sinh cho phép bất kỳ ai, kể cả người không có kỹ năng dựng phim, đều có thể tạo ra nội dung hoạt hình sống động với chi phí thấp và tốc độ nhanh. Điều này tạo điều kiện cho các kênh tung ra hàng loạt video mỗi ngày, trong đó không ít mang nội dung độc hại.

Ảnh minh họa

Ảnh minh họa

Một số người tạo video vẫn khẳng định mục tiêu là giáo dục, nhưng chất lượng thực tế rất khác biệt. Và hầu như không có bằng chứng nào cho thấy các nội dung được tham khảo hay kiểm duyệt bởi chuyên gia về phát triển trẻ em. Nếu chỉ nhằm tối ưu hóa lợi nhuận từ những sản phẩm "câu view" rẻ tiền, lời biện hộ "chúng tôi đang giúp trẻ học hỏi" trở nên thiếu thuyết phục.

Trên Substack The Intrinsic Perspective, nhà thần kinh học Eric Hoel từ Đại học Tufts (Mỹ) bày tỏ sự lo ngại sâu sắc trước mối kết hợp tiêu cực giữa nội dung hỗn loạn do AI tạo và thời lượng sử dụng thiết bị quá mức của trẻ em. Ông viết: “Trẻ con trên khắp đất nước đang ngồi trước iPad và chịu đựng dòng chảy nhân tạo. Không còn từ nào chính xác hơn ngoài ‘phản địa đàng’”.

Phía YouTube cho biết họ đã áp dụng bộ lọc tự động, đội ngũ kiểm duyệt thủ công và phản hồi người dùng để quản lý nội dung YouTube Kids. Nền tảng này cũng khẳng định đang triển khai chính sách mới, yêu cầu người sáng tạo phải công khai khi sử dụng AI để sản xuất nội dung có yếu tố thực tế.

Tuy nhiên, theo Wired, hàng loạt video vẫn dễ dàng lọt qua hệ thống kiểm soát. Việc trông chờ vào cơ chế tự báo cáo của nhà sáng tạo là không đủ, nhất là trong bối cảnh AI tạo sinh ngày càng mạnh mẽ. “Giám sát có ý nghĩa từ con người là điều tối quan trọng, đặc biệt với nội dung do AI tạo ra”, Tracy Pizzo Frey – cố vấn cấp cao về AI của tổ chức Common Sense Media – nhấn mạnh. “Và trách nhiệm này không thể đổ hết lên vai các gia đình”.

YouTube đã xóa nhiều kênh vi phạm và chặn tính năng kiếm tiền của một số tài khoản, đồng thời tuyên bố kết hợp công nghệ với con người để kiểm duyệt. Dẫu vậy, các kênh độc hại vẫn tiếp tục “mọc lại” bằng cách đổi tên, tạo tài khoản mới hoặc luồn lách qua những lỗ hổng kiểm duyệt.

Một số nhà sáng tạo nội dung và người dùng đã chủ động cảnh báo về hiện tượng này. Trong đó, một YouTuber có tên BitterSnake đã chia sẻ hình ảnh cho thấy một nhóm người, có thể ở nước ngoài, đang làm việc trong văn phòng để sản xuất hàng loạt video AI bạo lực thu hút hàng triệu lượt xem.

Những video này không chỉ ảnh hưởng tiêu cực đến trẻ em mà còn đặt ra dấu hỏi lớn về năng lực kiểm soát nội dung của các nền tảng. Khi AI ngày càng tinh vi, việc phân biệt giữa video thật và video nhân tạo trở nên khó khăn hơn bao giờ hết. Điều này đòi hỏi phụ huynh phải chủ động hơn trong việc giám sát con em, cùng con sử dụng mạng xã hội một cách tỉnh táo, đồng thời biết cách sử dụng công cụ báo cáo nội dung không phù hợp để bảo vệ môi trường mạng an toàn.

Các chuyên gia cũng kêu gọi sự vào cuộc trách nhiệm từ chính các nền tảng như YouTube, TikTok và các nhà sáng tạo, nhằm đảm bảo nội dung dành cho trẻ em không chỉ hấp dẫn mà còn an toàn, hữu ích và có giá trị phát triển.

GH